이 글에서는 gradient vanishing문제와 resnet이 gradient vanishing문제에 robust한 이유에 대해서 고찰하였다.

plain net

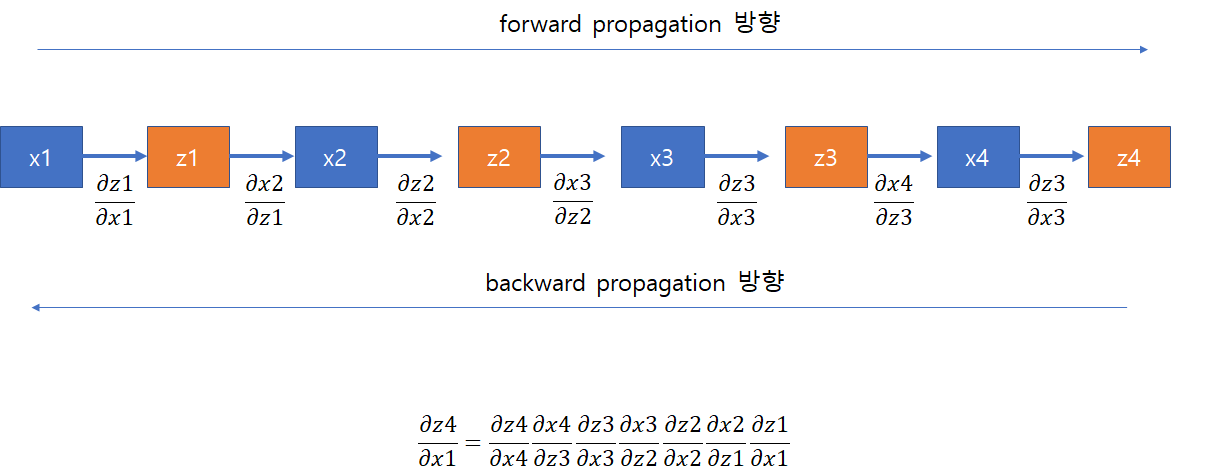

일반적인 plain net에서 backpropagation문제는 다음과 같이 수식으로 나타낼 수 있다.

그리고 위 그림과 수식을 참고하면 gradient는 앞 layer에 의존적이라는 것을 직관적으로 이해할 수 있다.

gradient vanishing문제는 이렇게 설명할 수 있다.

앞 layer에서의 backpropagation 결과가 0이 가깝다면 그 뒤는 자연스럽게 모두 0에 가까워질 수 밖에 없다.

만약 위의 수식에서 dx4/dz3 가 0에 가깝다면 수식 전체는 반드시 0으로 수렴한다.

그러나 resnet에서는 다음과 같이 network를 구성하였다.

항들이 곱하기 관계로만 묶여있는 것이 아니라 덧셈관계로도 묶여있기 때문에 dx4/dz3가 0이 된다고 해서 전체가 반드시 0으로 수렴하는 것은 아니다.

다음 그림을 통해서 이해를 돕도록 하겠다.

위 그림은 resnet의 구성이다. back propagation은 가장 아랫단에서부터 위로 올라가는 과정인데 1번 화살표를 보면 shortcuts을 편미분한 1이 넘어오기 때문에 0에 수렴하지 않는다는 것을 알 수 있다. 이런식으로 기울기가 소멸되지 않고 화살표 표시한곳마다 계속 gradient를 살려주기 때문에 나머지 shortcuts이 없는 중간층들도 gradient는 필연적으로 죽지않고 살아있음을 알 수 있다.

'연구 > papers' 카테고리의 다른 글

| [논문정리] GAN의 목적함수 읽는법 (0) | 2020.11.11 |

|---|---|

| [논문정리] (AlexNet) ImageNet Classification with Deep ConvolutionalNeural Networks (0) | 2020.10.01 |

| [논문 정리] Pose Machines: Articulated Pose Estimation via Inference Machines (0) | 2020.04.04 |

| [CPM 논문 정리] Convolutional Pose Machines (0) | 2020.04.03 |

| [논문 정리] openpose 이해를 위한 개념 간단 정리 (0) | 2020.04.02 |